“Se conosci il nemico e te stesso, non dovrai temere il risultato di cento battaglie.”

Sun Tzu, L’arte della guerra

Abstract

Nel mondo odierno, sempre più interconnesso, diventiamo ogni giorno più vulnerabili. Cyber criminiali, spie, Stati canaglia sono solo alcuni degli agenti di minaccia che popolano il campo di cyber battaglia. Ciononostante, chi si occupa di sicurezza continua a rimanere focalizzato sui tecnicismi, trascurando completamente i bias, sia cognitivi sia culturali, che sono alla base del comportamento umano. In questo saggio, suddividiamo la sicurezza umana applicata in tre sezioni, attingendo alle conoscenze derivanti da cyber security, cyber psicologia, teoria sistemica, social engineering, tassonomia di Bloom, teoria dell’apprendimento, economia comportamentale e scienze decisionali per capire come le aziende possono costruire la sicurezza intorno a – e per – l’uomo. Prima conosceremo il nemico, poi capiremo l’essere umano, e in conclusione proporremo delle azioni concrete che le aziende possono realizzare per rinforzare la propria cyber security.

Parte I: Il Nemico Introduzione

I notiziari sono invasi da storie di incidenti di sicurezza e data breach che hanno divulgato i dati personali, sensibili, riservati e segreti di milioni di persone. Numerosi professionisti del settore hanno dichiarato il 2017 come il peggiore anno in materia di incidenti di sicurezza, ma le previsioni per il 2018 sono anche peggiori. In aggiunta a uno scenario di minacce che cambia rapidamente e costantemente, le tecnologie emergenti quali l’Intelligenza Artificiale, l’apprendimento automatico e il calcolo quantistico stanno cambiando radicalmente la maniera in cui l’era moderna affronta la cyber security e rendono sempre più difficile rimanere “un passo avanti”.

In concreto, possiamo guardare al panorama cyber come a un campo di battaglia in cui una delle armi chiave sono le informazioni. In una società completamente permeata dall’informazione, il potere viene dal possesso e dallo sfruttamento tempestivi e puntuali di questi dati.

L’epicentro della battaglia siamo noi, gli esseri umani. Diverse analisi identificano noi umani come l’anello debole dello scenario cyber, vulnerabili a un numero infinito di tecniche di inganno e sfruttamento. Veniamo condizionati dalla situazione digitale intorno a noi, ma le nostre risposte nel contesto cyber non sono istintive e“logiche”, ma sono radicalmente plasmate dalle nostre convinzioni personali, dai nostri bias, e da quello che sappiamo.

Ecco perché questo breve saggio, centrato sull’elemento umano della cyber security. Partendo dalla citazione del famoso testo di Sun Tzu L’arte della guerra in prima battuta parleremo dell’ambiente esterno, “il nemico”, che costituisce il panorama in cui si muove la minaccia umana; nella seconda sezione, analizzeremo i bias euristici su cui si basa la risposta umana a queste minacce; e infine, nella terza sezione, cercheremo di definire come si possa costruire intorno e per questi bias, di modo da rinforzare concretamente la cyber security umana.

Il nemico: Minacce dall’ambiente esterno

Se consideriamo l’essere umano come un “sistema” nel contesto della teoria sistemica, l’ambiente esterno è un elemento di invio input verso il processo decisionale di ogni persona. Questi input possono essere “buoni”, ma possono essere anche “malevoli” e falsare il modo in cui prendiamo decisioni. Questo è il “nemico” che dobbiamo combattere per poter fare scelte migliori e rendere più sicura la sfera cyber.

La sfera virtuale

Mentre la tecnologia si evolve e modifica il nostro operato quotidiano, lo stesso avviene al comportamento umano. Psicologi come la Dottoressa Mary Aiken ritengono che le persone si comportino diversamente quando interagiscono nella sfera astratta del cyber spazio e quando invece agiscono nel mondo reale, faccia a faccia. Il termine “cyber” qui si riferisce a qualsiasi elemento digitale, dalla tecnologia Bluetooth alle auto senza conducente ai cellulari agli apparati di rete all’intelligenza artificiale e all’apprendimento automatico.

Quindi: in che modo il cyber sta condizionando il nostro processo decisionale?

Minaccia numero uno: cyber safety è un termine astratto. Le persone comprendono più facilmente ed efficacemente i rischi connessi al guidare ubriachi che quelli legati all’avere connesso ad Internet un computer non patchato. Di conseguenza, le persone spesso non riconoscono un rischio o l’elemento lanciato per attrarle, e credono di essere meno vulnerabili degli altri. Come dice Ryan West, molta gente crede di essere meglio del guidatore medio e di poter vivere una vita più lunga della media. Sono anche convinte di essere meno esposte ai pericoli dei prodotti di consumo rispetto alla media. Quindi è ragionevole pensare che chi usa un computer abbia lo stesso set preconfigurato di convinzioni e creda perciò di essere meno esposto alle vulnerabilità informatiche. Inoltre la scelta di sicurezza (per esempio, la cifratura delle mail) spesso non dà risultati visibili, così come tipicamente non sono “visibili” le minacce (per esempio, qualcuno che vuole intercettare la posta aziendale). La ricompensa per il comportamento più sicuro, quindi, è nel fatto che non accade nulla di male: ma questo, per sua stessa natura, non mette le persone nella condizione di considerare la sicurezza come un valore quando devono comparare costi, benefici e rischi. Se infatti paragoniamo l’astratta ricompensa (protezione) di essere più sicuri rispetto alla ricompensa concreta di vedere, ad esempio, un attachment, il risultato è sfavorevole per la sicurezza. Questo è specialmente vero quando un utente non sa quanto sia alto il proprio livello di rischio, o crede di essere meno esposto della media.

Il cyber crea dipendenza. Uno studio ha dimostrato che l’utente medio controlla il proprio smartphone più di 1500 volte a settimana. Ed è la natura stessa della rete ad intensificare questo fenomeno. Internet è sempre lì, aperto, 24/7, pieno di promesse, contenuti e dati. È anche colmo di ricompense a intermittenza, che sono molto più efficaci della ricompensa continuativa nel creare dipendenza. Ricordate il film C’è posta per te con Tom Hanks e Meg Ryan? A un certo punto, Tom Hanks dice che non c’è nulla di più potente delle semplici parole “Hai una mail”. Questa è la vera essenza della dipendenza digitale – controlliamo i nostri device perché qualche volta siamo abbastanza fortunati da essere ricompensati con una notifica.

Quando qualcosa dà dipendenza, tendiamo a fare scelte irrazionali ogni qualvolta dobbiamo prendere decisioni che lo coinvolgono in qualche modo. Cerco quindi sono; ottengo like quindi esisto. Controlliamo la nostra mail, ora, e di nuovo, e di nuovo.

Questo ci porta dritti a un’altra minaccia, il tempo che passiamo online. Quando controlliamo il cellulare, o anche mentre stiamo scrivendo questo documento, ci troviamo effettivamente in un ambiente diverso; siamo andati da un’altra parte rispetto al tempo e allo spazio del mondo fisico. Perché il cyberspace è uno spazio distinto, molto diverso dallo spazio concreto in cui si trovano le nostre famiglie, le nostre case, il nostro lavoro. Molti di noi hanno provato la sensazione di “aver perso il senso del tempo” mentre navigavano online, perché non abbiamo ancora imparato a tenere traccia del tempo nella sfera virtuale. E questo ha conseguenze profonde su come ci comportiamo e le decisioni che prendiamo nel virtuale. (E per quanto riguarda la sicurezza, più tempo significa più rischi.).

Questo ci porta dritti a un’altra minaccia, il tempo che passiamo online. Quando controlliamo il cellulare, o anche mentre stiamo scrivendo questo documento, ci troviamo effettivamente in un ambiente diverso; siamo andati da un’altra parte rispetto al tempo e allo spazio del mondo fisico. Perché il cyberspace è uno spazio distinto, molto diverso dallo spazio concreto in cui si trovano le nostre famiglie, le nostre case, il nostro lavoro. Molti di noi hanno provato la sensazione di “aver perso il senso del tempo” mentre navigavano online, perché non abbiamo ancora imparato a tenere traccia del tempo nella sfera virtuale. E questo ha conseguenze profonde su come ci comportiamo e le decisioni che prendiamo nel virtuale. (E per quanto riguarda la sicurezza, più tempo significa più rischi.).

In ultima battuta, dobbiamo tenere in considerazione la natura libertaria di Internet. Internet è progettata per essere libera. Ma dove finisce la libertà e inizia il totalitarismo? Quali e dove sono i confini fra libertà e corruzione? La “libertà di parola” è fake news? E chi decide che certe opinioni sono fake news, ammesso che qualcuno debba e possa deciderlo? Allo stesso modo, l’interesse personale come può surclassare quello della più ampia community virtuale? L’idea della libertà online è piuttosto controversa, e solleva diverse questioni etiche, ma al momento esiste davvero poca regolamentazione.

Dovrebbe essere chiaro che il nostro ambiente ha un impatto sui nostri processi decisionali. I nostri istinti si sono evoluti attraverso la storia per gestire le interazioni faccia a faccia con altri esseri umani, ma una volta che ci addentriamo nella sfera virtuale, questi istinti non bastano più.

La tecnologia in continua evoluzione

Man mano che i gadget e i device cambiano, cambia anche la sfera virtuale, e di nuovo questo comporta delle conseguenze su di noi. Più cambiamenti portano a più situazioni nuove, creando più confusioni. Fino a diversi decenni fa, il passo di qualsiasi rivoluzione tecnologica era tale da consentire agli uomini di assorbire il cambiamento e integrarlo nella loro quotidianità. Nel corso degli ultimi venti anni, invece, l’evoluzione della tecnologia digitale è diventata così frenetica che le persone non riescono a starle dietro. Non dobbiamo certo elencare tutte le parole d’ordine e i tormentoni che nascono ogni singolo giorno come riprova di questo argomento.

Persino i “nativi digitali”, per usare la discussa terminologia di Marc Prensky, a volte si sentono spaesati di fronte alla tecnologia sempre mutevole. Non abbiamo ancora trovato un modo per utilizzare a nostro favore questa tecnologia; non sappiamo con certezza come usarla efficacemente e sicuramente; e non sappiamo quali saranno le conseguenze a lungo (e breve, anche) termine di tutte queste neonate tecnologie.

Certamente vi sono buone pratiche per integrare queste tecnologie nelle nostre vite, ma vi sono anche cattive pratiche che molti di noi seguono allo stesso modo. Oltretutto, la tecnologia ha creato anche una rivoluzione senza precedenti in materia di creazione di contenuti digitali. Questo solleva molti interrogativi: quali sono le implicazioni dell’esporre così tanti dati sensibili online? Chi ne trae beneficio? Possiamo proteggere i nostri asset più preziosi, o stiamo aprendo le nostre case ai peggiori criminali che potrebbero cancellare le nostre vite con un solo click? (Ricordate il film The Net con Sandra Bullock?)

La tecnologia non è buona o cattiva di per sé, è neutrale; semplicemente si interpone, amplifica e cambia il comportamento umano. Può essere usata bene o male dal genere umano; per molti versi, non è diverso da come decidiamo di guidare l’auto o usare l’elettricità o l’energia nucleare. Ogni tecnologia può essere usata male. Di qui, la domanda centrale: qual è l’etica universalmente accettabile per l’utilizzo della tecnologia cyber?

L’educazione

L’educazione è ovviamente uno dei fattori che plasmano il comportamento umano. Abbiamo letto un numero infinito di articoli sulla necessità di investire nella formazione. A livello macroscopico, la diffusa mancanza di educazione può trasformarsi in ignoranza, autoritarismo, o persino anarchia. L’attuale mancanza di una formazione esaustiva riguardo la sfera virtuale può creare problemi al modo in cui le persone percepiscono la dimensione cyber, i suoi rischi e le sue minacce.

Un altro tema è l’efficacia dell’educazione digitale già esistente. L’educazione dovrebbe avere come obiettivo la risposta ai“perché”e non solo ai “come” della sicurezza. Dovrebbe puntare a una comprensione profonda, a far rimanere le cose che vengono insegnate, e naturalmente dovrebbe essere continuativa. Sfortunatamente, non è questo il caso. L’approccio pedagogico tipico si basa sul rinforzo positivo quando facciamo qualcosa di “giusto”. In altre parole, quando facciamo bene qualcosa veniamo premiati. Nel caso della sicurezza, però, quando l’utente fa qualcosa di “giusto”, l’unica ricompensa è che diminuiscono le probabilità che accada qualcosa di male. È un risultato piuttosto astratto, che non fornisce né gratificazioni né ricompense immediate, che sono entrambi due rinforzi importanti nella conformazione di un comportamento.

Dovremmo esaminare anche il caso opposto, come viene plasmato il nostro comportamento dal rinforzo negativo quando facciamo qualcosa di “sbagliato”. Normalmente, quando facciamo qualcosa di male in un contesto educativo, ne subiamo le conseguenze. Nel caso della sicurezza, invece, il rinforzo negativo per un cattivo comportamento non è immediatamente evidente. Può essere posticipato di giorni, settimane, mesi, ammesso che arrivi mai. (Pensate a una violazione della sicurezza o a un furto d’identità, per esempio.) Il rapporto causa-effetto si impara meglio quando l’effetto è immediato, mentre la scelta anti-sicurezza spesso non ha conseguenze immediate. Questo rende difficile promuovere la comprensione delle conseguenze, tranne nel caso di disastri spettacolari. Inoltre, bisogna tenere conto del fatto che fattori quali forza di volontà, motivazione, percezione del rischio, costi e opportunità sono spesso più importanti della mancanza di conoscenza in sé.

Social Engineering

Gli attacchi via social engineering, orchestrati per lo più attraverso messaggi di phishing, rimangono una minaccia persistente che consente agli hacker di aggirare i controlli di sicurezza. Sfruttando le loro abitudini, motivazioni e bias cognitivi, è possibile manipolare le persone perché rivelino informazioni confidenziali. Le ricerche sul phishing si concentrano in particolare sulla capacità dell’utente di rilevare anomalie strutturali e fisiche nelle mail, come ad esempio errori di ortografia o le differenze fra l’URL mostrato e quello incorporato nel codice HTML. Ma le persone spesso “processano” una mail usando modelli mentali o euristici, e quindi trascurando gli indizi che mostrano l’inganno. Inoltre, le abitudini, le necessità e i desideri della gente la rende vulnerabile agli attacchi di phishing che promettono ricompense.

La sensibilità rispetto ai messaggi di phishing è cresciuta molto fra gli utenti, ma altrettanto è cresciuta la capacità degli attaccanti di falsificarli. Oggi, gli hacker progettano i messaggi in modo da scatenare reazioni (paura, rapacità, altruismo) e spesso scelgono come obiettivi dei gruppi specifici cui fare richieste specifiche. A volte arrivano persino a personalizzare il messaggio inserendo informazioni personali del destinatario (spear phishing). Ad esempio, è stato rilevato un nuovo tipo di phishing sulle app per appuntamenti: un bot che si spaccia per un utente avvia una conversazione con un altro utente (la vittima) e, dopo qualche scambio, gli invia un link malevolo, spesso con una foto, nel tentativo di convincerlo a cliccarlo. Le ricerche mostrano che questo tipo di attacchi spear sono più efficaci del phishing generico, che punta a una popolazione più ampia.

Gli attori malevoli

In questi giorni, il cybercrime è più organizzato che mai. I cyber criminali sono forniti di strumenti e fondi adeguati, oltre ad avere le conoscenze necessarie per portare a termine il lavoro. Ma per capire fino in fondo i cyber criminali, dobbiamo sapere una cosa sopra tutte le altre: le loro motivazioni. I cyber criminali sono interessati al denaro. Usano i ransomware per estorcere denaro, o sottraggono i dati che possono essere rivenduti sul dark web. Il loro modus operandi passa principalmente per le campagne di phishing, che sono solitamente a basso costo e possono dare un ritorno dell’investimento inziale davvero sbalorditivo. Tipicamente, queste campagne sono utilizzate per distribuire malware (spesso ransomware), e le mail si fondano in maniera significativa sul social engineering. Ad esempio, ai destinatari è spesso richiesto di aprire o inoltrare l’allegato, di solito falsi documenti di lavoro, che all’apertura attiva il software malevolo.

A differenza dei cyber criminali, gli hactivisti non sono motivati dal denaro, quanto piuttosto dalla vendetta. Gli hactivitsti lavorano da soli, rendendo molto difficile predire i loro attacchi o rispondere velocemente. A volte, gli hactivisti sono interni, che sanno come bypassare le misure di sicurezza dell’organizzazione, ma il rischio maggiore è sempre connesso al fatto che è difficile risalire a chi siano e a quando attaccheranno, e spesso anche a perché lo facciano. Se non altro sappiamo che il loro modus operandi preferiti è il DDoS (distributed denial of service), perché mette in imbarazzo le vittime.

Negli ultimi anni, abbiamo ricevuto notizie in merito ad attacchi e cyber spionaggio finanziati dai governi. In maniera ben poco sorprendente, gli attaccanti stipendiati dai governi non sono interessati ai nostri soldi: vogliono i nostri dati, e per farlo devono riuscire a garantirsi un accesso costante (“persistente”) alle nostre infrastrutture IT. Se un’azienda opera in un campo particolarmente sensibile, in cui i dati sono meticolosamente salvaguardati (ad esempio, infrastrutture critiche o voti elettorali), allora rischia seriamente di essere oggetto di attenzione da parte di hacker “governativi”. In estrema sintesi, visto che c’è così tanto online, i gruppi “governativi” lavoreranno simultaneamente su molteplici vettori d’attacco. In questo modo, possono raccogliere dati sensibili lungo un ampio arco temporale, invece che puntare a semplici “raid”.

Conclusioni

Quello virtuale è il campo di battaglia in cui possono collidere interessi diversi. Nella foschia e fra la polvere sollevata da questa collisione c’è l’essere umano, che è il collettore di molti input, buoni e cattivi, in grado di modificare il modo in cui si comporta e reagisce, Ma anche senza tenere in considerazione questi input esterni, tutti i bias cognitivi ed euristici di ogni persona giocano un ruolo primario, di cui parleremo nella seconda sezione.

Parte II: L’essere umano Introduzione

Nella prima parte di questo saggio, abbiamo parlato del “nemico”, l’ambiente esterno che crea le minacce cui gli esseri umani devono rispondere. In questa seconda sezione ci concentreremo sulle convinzioni e i bias che plasmano le nostre azioni nel panorama cyber. Facendo riferimento a quanto sappiamo in materia di economia comportamentale, cyberpsicologia, social engineering e scienze decisionali, risponderemo a una delle domande fondamentali della cyber security: perché l’uomo è l’anello debole?

L’essere umano

I fattori che tengono in piedi la sicurezza informatica di un’azienda sono innumerevoli: dai firewall e gli standard di crittografia ai protocolli di reportistica degli incidenti e a tutta la cultura di sicurezza. Molte organizzazioni cercando sempre di rimanere in pari, quando si parla di tecnologia informatica solida, ma i dipendenti rimangono per lo più vulnerabili.

Gli esseri umani sono fallibili sia nel ricordare le informazioni (ad esempio, di un corso d’aggiornamento) sia nell’usarle (ad esempio, prendere decisioni quando usano la tecnologia), il che mette tutte le grandi organizzazioni a rischio. I numeri lo mostrano con chiarezza: le statistiche dell’anno scorso indicano che più di due terzi di tutti gli incidenti di sicurezza sono stati causati da errore, utilizzo o manipolazione umana, come nel caso di attacchi di phishing e spear phishing. Gli hacker sono consapevoli della vulnerabilità rappresentata dal fattore umano, e sono ben felici di poterla sfruttare, come abbiamo spiegato nella Sezione I.

Euristica delle decisioni e cyberpsicologia

Il nostro cervello è evoluzionisticamente programmato per diminuire il tempo che dedichiamo alle decisioni attraverso l’uso dell’euristica delle decisioni: in pratica, un sistema semplice ed efficace di regole che guidano il nostro giudizio. Ma mentre queste scorciatoie cognitive sono di grande beneficio per diverse ragioni, dall’altra parte ci lasciano esposti ai bias euristici, che possono farci incorrere in errori di giudizio e supposizioni sbagliate quando valutiamo un set di decisioni. Sono fondamentali per capire come si muove l’essere umano nella sfera virtuale.

Diversa ma legata al discorso è la cyberpsicologia, un campo di studi emergente dedicato alla comprensione di come gli essere umani interagiscono con, e sono modificati da, la tecnologia. Mentre le scienze decisionali studiano i processi decisionali e le loro applicazioni a tutto tondo, la cyberpsicologia è specificatamente dedicata alla tecnologia, e si interroga su quali comportamenti cambino quando entriamo nella sfera virtuale e quali no. Non è probabilmente una grande sorpresa scoprire che è più frequente il caso in cui il comportamento cambia significativamente (addirittura, a volte, radicalmente) appena ci sediamo di fronte allo schermo. L’esperta del settore D.ssa Mary Aiken chiama questo mutamento repentino l’effetto cyber, e vi riconduce tutto, dall’amplificazione comportamentale alla disinibizione online.

Ma ci torniamo fra poco.

Password e login

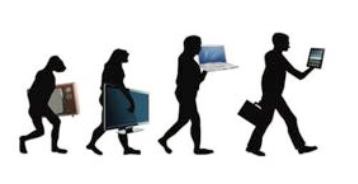

Gli esperti di sicurezza e i professionisti dell’IT raccomandano continuamente le best practices per l’uso delle password, eppure la maggior parte delle persone non le seguono. E questo perché creare e conservare una password rappresenta una sfida significativa per molte persone. Prima di tutto, la maggior parte di noi tende a scegliere password memorizzabili, siano i nomi dei nostri familiari, le date importanti, o il titolo del nostro film preferito. Le scegliamo memorizzabili perché ne usiamo un grande numero; è praticamente impossibile per chiunque memorizzare tutte le password di tutti i nostri account, email, social media, servizi di streaming, siti di e-commerce, database lavorativi e home banking.

Questa tendenza a creare password memorizzabili c’era quando le vecchie linee guida del NIST suggerivano di usare insiemi casuali di lettere, numeri e simboli, e c’è anche ora che il NIST suggerisce l’uso di passphrase lunghe e complesse. Semplicemente, è più facile ricordare informazioni rilevanti per sé che un insieme random di lettere e numeri. Quindi sceglieremo più probabilmente password come 125elmST (un vecchio indirizzo) o johnlucyjacksarah (i nomi dei figli) che non e7@4j8!9.

Indubbiamente bisogna fare dei compromessi fra robustezza della password, mutevolezza e facilità di memorizzazione: avere molto password memorizzabili è un compromesso rispetto a una sola password molto complessa (e non memorizzabile). Il problema però è che le password memorizzabili sono facili da “craccare” per qualcuno che pratichi social engineering. Pochi minuti con Kali Linux o qualsiasi altro strumento di penetration test mostreranno rapidamente la pletora di software disponibili per questo scopo, da dizionari pre-assemblati di password popolari a script che inseriscono le informazioni di un target (nome, coniuge, domicilio) all’interno di dizionari di password customizzati. I nostri prevedibili comportamenti lasciano noi, e per estensione i nostri amici, familiari, impiegati e colleghi, vulnerabili alla possibilità di essere hackerati.

Quando veniamo costretti a cambiare le nostre password, che ce lo chieda un sistema operativo o la politica aziendale, tendiamo a sovrapporre le nuove sulle vecchie. Se la mia password attuale è strongP@ssw0rd!123, è probabile che quella nuova sarà qualcosa come strongP@ssw0rd!456 o anche strongerP@ssw0rd!123, così da non dover memorizzare una nuova frase. Abitudini e schemi ricorrenti, in particolare nel cyberspazio, sono importanti, da cui deriva la definizione di bias dello status quo, o preferenze di default (in altre parole, lasciare le cose come stanno anziché cercare di gestire il cambiamento). Di nuovo, però, questo comportamento prevedibile rende gli essere umani vulnerabili. Se un hacker sta usando nell’ombra le credenziali di un impiegato, e all’improvviso si accorge (poiché non riesce più ad accedere) che la password è stata cambiata, probabilmente farà leva sulla conoscenza di questo bias e farà qualche tentativo con password simili alla precedente, cambiando numeri o lettere, come negli esempi che abbiamo appena fatto. In questo modo, la lunghezza della password diventata immediatamente ininfluente.

Riconoscere le minacce: Phishing, social engineering, e altro

I bias euristici ci rendono incredibilmente vulnerabili – e inefficaci – quando si parla di individuare le minacce informatiche, e sono peggiorate dal fatto che non possiamo contare sui nostri “istinti” consueti né sul linguaggio noto quando entriamo nella sfera virtuale. È a questo che mirano gli attaccanti, come abbiamo detto prima. Gli esseri umani vogliono avere fiducia, e questo è mostrato con chiarezza dall’efficacia degli attacchi phishing. Possiamo essere istruiti a riconoscere come è fatta una mail di phishing; possono dirci di non fidarci mai di una mail inviata da un mittente sconosciuto; possono persino insegnarci a non fidarci di email sospette inviate da mittenti noti. Ma in pratica, questo modello non funziona. Nella nostra casella di posta ogni anno passano molte mail di phishing (confermato anche dai dati sulle violazioni di sicurezza nelle aziende), ma la maggior parte della posta elettronica che riceviamo non lo è. Ogni volta che apriamo una mail apparentemente sospetta che si rivela sicura, che ci piaccia o meno stiamo cadendo in un bias di conferma. L’idea preconcetta che non dobbiamo controllare ogni mail si rinforza ogni volta che ne apriamo una sospetta senza conseguenze negative. In questo modo, l’attenzione prestata a ogni mail sospetta diminuisce col tempo, aumentando le possibilità che un attacco di phishing avvenga con successo.

Anche la rappresentatività ricopre un ruolo, qui. Quando svolgiamo ripetitivamente un compito, il nostro cervello categorizza insieme la piccole possibili variazioni, di modo da ridurre il tempo decisionale. Per esempio, se un manager invia ogni venerdì una mail di “Recap settimanale”, gli impiegati non noteranno un “recap settimanale”, mandato di venerdì, che non proviene però dall’indirizzo email del capo. La nostra tendenza a raggruppare erroneamente le nuove situazioni all’interno di confini già noti può essere letale; è per questo che gli esperti di social engineering sono sempre alla ricerca di modi in cui inserire URL, documenti e altre features malevole all’interno di pattern comportamentali noti.

Aggiungere il concetto di disinibizione online al quadro mostra quando siamo vulnerabili agli attacchi di social engineering: i primi risultati delle ricerche di cyberpsicologia mostrano che siamo molto più avventati online che non nelle nostre interazioni vis-a-vis; la D.ssa Aiken arriva a paragonare alcuni nostri comportamenti virtuali a uno stato di ubriachezza, visto che ci fidiamo più facilmente del prossimo e riveliamo più velocemente informazioni personali. Questo, unito alla iper-interazione virtuale (diminuzione delle barriere sociali all’intimità e allo scambio di informazioni) e alla sindrome dello straniero sul treno (la tendenza a rivelare informazioni sensibili con coloro che pensiamo di non vedere mai più), mostra quanto siamo già inclini a condividere troppe informazioni online, e il tutto è aggravato dagli attori malevoli capaci di sfruttare i nostri bias euristici. Il modo in cui ci comportiamo online, e il modo in cui decidiamo su cosa cliccare e cosa condividere, sono tutte ragioni che concorrono a rendere l’uomo l’anello debole della catena virtuale.

Legato a queste idee c’è un altro elemento con cui tutti facciamo i conti: il bias ottimista, la convinzione di navigare il mondo meglio di tutti gli altri. Nel mondo fisico, questo succede in continuazione. Tendiamo a esentarci da regole, politiche e standard il cui rispetto pretendiamo dagli altri perché riteniamo di esserne al di sopra; per esempio, molti tendono a scrivere messaggi al cellulare mentre guidano, nonostante i numeri che mostrano con forza come questo sia pericolosissimo per sé e per gli altri, perché reputano che loro, a differenza degli altri, siano multitasking. (E diversi studi, ovviamente, mostrano come il“multitasking”nella sua accezione più piena sia impossibile.) E questo si trasferisce pari pari nella dimensione virtuale, dove tutti classifichiamo le nostre performance sopra la “media” e quindi cadiamo al di sotto degli standard minimi di sicurezza informatica. Se un impiegato provoca un incidente di sicurezza a causa di una password debole, con ogni probabilità lo criticheremo; tuttavia, con la stessa probabilità, ci concediamo di salvare le password nel browser o di aggirare l’autenticazione multifattore senza criticarci. Allo stesso modo, un impiegato può essere ben consapevole dei pericoli rappresentati dal social engineering ma non prestare attenzione a evitare gli attacchi di phishing, semplicemente perché ritiene di non averne bisogno, e anche se lo critichiamo, molti di noi probabilmente fanno la stessa cosa.

Gli esseri umani sono anche esposti all’effetto recency, che ci rende più sensibili alle informazioni fornite di recente. Se ad esempio un impiegato segue un corso di tre ore sui pericoli del malware, sarà più attento a ciò che scarica da Internet che non alle email di phishing. Questo sembra ovvio, ma il bias euristico che vi sottintende è critico per la vulnerabilità umana: la minaccia “recente” sarà la minaccia prioritaria. Di conseguenza diventa importante l’ordine in cui si fa formazione.

Il bias di frequenza, o il favorire le informazioni ribadite, ha conseguenze simili su ciò che ci portiamo via dalla formazione e sensibilizzazione. È sensato che più un argomento è discusso più ne è percepita l’importanza, ma in materia di sicurezza semplicemente ci sono troppo argomenti per poterli coprire tutti in maniera adeguata, e questo è un problema. Se un’azienda organizza 5 ore di formazione sul tema della cifratura delle mail o la creazione delle password, ma ne dedica solo 3 agli attacchi di phishing e social engineering, con ogni probabilità i dipendenti riterranno prioritario difendersi dai primi, mentre il social engineering rappresenta un rischio più grave. Bilanciare il tempo dedicato a una minaccia informatica con la percentuale di sua concretizzazione è una questione complessa (di cui parleremo nella prossima sezione), ma dobbiamo tenere in considerazione questo bias.

Conclusioni

Il comportamento umano nella sfera virtuale è incredibilmente fallace, dalle vulnerabilità delle decisioni euristiche ai bizzarri comportamenti che adottiamo solo perché abbiamo poca familiarità con la tecnologia. Comprendendo meglio le scienze decisionali, l’economia comportamentale e la cyberpsicologia, possiamo migliorare la sicurezza umana applicata. Quindi, avendo analizzato sia il “nemico” sia “l’umano”, la terza e ultima sezione si concentrerà sul “vincere la battaglia”, ovvero definire la sicurezza informatica tenendo a mente la componente umana.

Parte III: Vincere la battaglia Introduzione

La prima parte di questo saggio, “Il Nemico” era incentrata sull’ambiente esterno e le minacce che introduce nel panorama virtuale, mentre la seconda parte “L’essere umano” ha discusso i bias euristici e i preconcetti che definiscono la risposta umana a queste minacce. Nella parte conclusiva, vogliamo affrontare come “non temere il risultato di cento battaglie” o, in altre parole, come definire le politiche di sicurezza intorno e per l’essere umano.

Background teoretico

Diversi decenni fa, lo psicologo dell’età evolutiva Jean Piaget dichiarò che “il principale scopo dell’educazione è formare uomini che siano capaci di fare cose nuove, non ripetere semplicemente ciò che hanno fatto le altre generazioni – uomini che siano creativi, inventivi e portati alla scoperta”.

Partendo da qui, possiamo guardare all’apprendimento come a un processo di acquisizione e costruzione di conoscenze con forti componenti sociali ed esperienziali.

La ricerca in materia di formazione ha mostrato che le persone possono imparare più efficacemente e approfonditamente attraverso l’impegno, la motivazione, la cooperazione, la collaborazione la partecipazione in esperienze reali. Quindi, i metodi convenzionali di insegnamento non possono soddisfare i requisiti di apprendimento odierni. Costruire e condividere conoscenza arricchisce l’efficacia dell’insegnamento e il curriculum, con una significativa distanza dall’educazione burocratica che preferisce la quantità alla qualità, e guarda alla motivazione innata. Attraverso tecniche e metodologie quali forum di discussione ed esercizi concreti, piccoli gruppi di persone possono sviluppare il pensiero critico, imparare a mobilitarsi verso un obiettivo comune, e fare affidamento su un’intelligenza collettiva che è superiore alla somma di quella dei singoli individui.

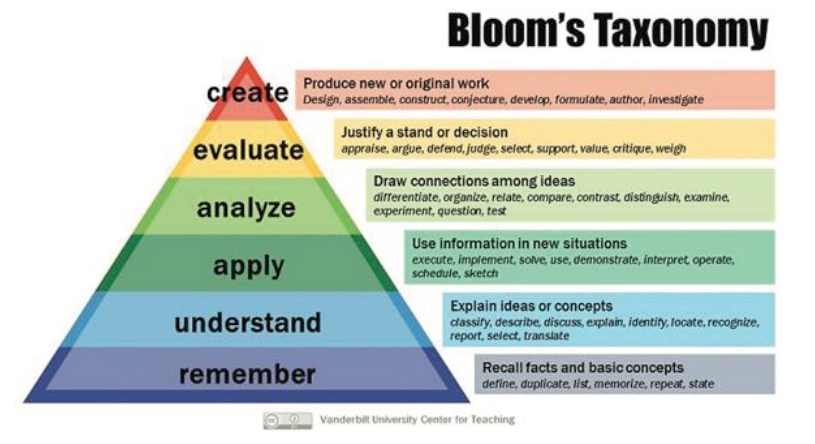

Secondo la tassonomia di Bloom, tuttavia, l’insegnamento non dovrebbe concentrarsi solo sul trasmettere informazioni, ma anche sulla loro applicazione. Usare vecchie informazioni per risolvere nuovi problemi è essenziale per memorizzare ciò che si apprende e sviluppare nuova conoscenza. Prevedibilmente, si attiva molto velocemente un ciclo ripetitivo, in questo: le vecchie conoscenze vengono rinforzate dall’applicazione, e l’applicazione richiede nuove conoscenze da applicare e via così. Il prodotto di questo processo è spesso chiamato deep learning. La ludicizzazione e la simulazione sono due esempi di applicazione del processo di deep learning.

Default e “spinte gentili”

Nel loro testo del 2009 Nudge. La spinta gentile, gli economisti Richard Thaler e Cass Sunstein, hanno definito l’idea del paternalismo libertario;

un modello decisionale dove nessuno vede le proprie scelte limitate o falsate (l’elemento libertario), ma in cui, inquadrando le scelte in un certo modo, i creatori possono aiutare le persone a selezionare l’opzione migliore (l’elemento paternalista). In sostanza, l’idea è di spingere gentilmente gli individui nella giusta direzione senza limitarne la libertà. Ci sono molti modi di ottenere questa “spinta gentile”, per esempio ordinare in maniera diversa le opzioni e aumentare la quantità di informazioni di base disponibili, ma noi vogliamo focalizzarci su un metodo in particolare: cambiare le impostazioni predefinite.

Le impostazioni predefinite sono incredibilmente potenti quando entrano nel processo decisionale, come mostrano i tanti studi di scienze decisionali ed economia comportamentale. A causa del bias dello status quo – vale a dire, la nostra avversione a mettere impegno nel cambiamento – molti di noi probabilmente sceglieranno di adeguarsi alle impostazioni predefinite in ogni scenario decisionale. Nudge. La spinta gentile evidenzia quanto questo sia vero in ogni campo, dai buffet delle sale refettorio dei college ai piani pensionistici delle aziende. Per tutte queste ragioni, la sicurezza-di-default è una delle maniere più efficaci di “vincere la battaglia” quando parliamo di sicurezza umana applicata. Rendere la sicurezza informatica lo status quo garantirà complessivamente un comportamento più sicuro, perché molti utenti rimarranno ancorati alle impostazioni predefinite.

L’idea del “default” ha molte implicazioni nel modo in cui le aziende progettano, svolgono e rinforzano la formazione in materia di sicurezza, ma di questo parleremo fra poco, per ora concentriamoci sul modo in cui le organizzazioni possono inserire la sicurezza di default nella loro catena tecnologica.

Attivare la cifratura più robusta possibile su tutti i device acquistati per la vostra organizzazione, smartphone, laptot, sensori IoT. Installare software di crittografia, e impostarli come predefiniti sui sistemi di comunicazione, da Signal a PGP. Limitare l’accesso a Internet (ad esempio, ai soli siti relativi alle mansioni lavorativi) e fare in modo che tutti gli account abbiano il set minimo di privilegi necessari allo svolgimento di attività base (ad esempio, impedire l’installazione di software). Attivare i filtri sulle email, impostare l’autenticazione multifattoriale, e definire i requisiti minimi delle password. Configurare i software di rimozione malware, firewall interni ed esterni, e la sospensione automatica delle sessioni dopo un periodo di inattività. Tenere costantemente sotto controllo le nuove linee guida di settore e le ricerche più recenti per mantenere sempre aggiornata la sicurezza di default – per esempio, come si configura una password robusta. Ma soprattutto, evitate che i dipendenti debbano gestire complicate e fastidiose attività di controllo, quando possibile: se devono accumulare malumore perché chiedete loro di verificare due volte che le loro USB personali non siano state hackerate, semplicemente vietatene l’uso. In uno scenario di sicurezza di default, anche i dipendenti e gli utenti sono più protetti.

È importante tenere presente che questi meccanismi di sicurezza di default non dovrebbero essere proposti come scelta libera. La cifratura e l’autenticazione multifattoriale sono due classici esempi per i quali non dovrebbe sussistere l’opzione out: i dipendenti non dovrebbero poter disattivare la cifratura o diminuirne il livello di robustezza, così come non dovrebbero poter utilizzare l’autenticazione a fattore singolo (username e password). Quando si parla di sicurezza, l’assenza dell’elemento libertario funziona meglio.

Euristica delle decisioni, sistema di feedback e formazione sulla sicurezza

Come detto in precedenza, i corsi di formazione e aggiornamento sulla sicurezza al momento non sono adeguati ad affrontare le minacce provenienti dal cyberspazio, così come i bias cognitivi ed euristici che guidano il nostro comportamento online. Anche all’interno di sistemi progettati in un’ottica di sicurezza di default, non siamo in grado di proteggerci da situazioni in cui a) le aziende non possono configurare la sicurezza come impostazione predefinita, perché il controllo finale spetta al fattore umano e b) il fattore umano modifica quell’impostazione, rendendo il processo meno sicuro.

La soluzione classica (e più diffusa al momento) a questo problema è quella di imporre una chiara politica di sicurezza aziendale, per esempio gli utenti non possono utilizzare supporti USB esterni. Questo sembrerebbe efficace, perché la struttura aziendale incentiva intrinsecamente la compliance a queste politiche… giusto? Sbagliato. In un’ottica umana, questo approccio è con ogni probabilità destinato a fallire per diverse ragioni.

Gli utenti non rispetteranno la policy perché non comprendono la gravità del rischio. Potrebbero non conoscere la policy o averla dimenticata. Potrebbero insorgere situazioni contingenti in cui gli utenti hanno necessità di ricorrere un device USB, e quindi opteranno per un’eccezione funzionale (convenienza prima che sicurezza).

Gli esseri umani sono vittime del bias ottimista – pensano di essere migliori di altri in certe cose – e quindi si auto-esenteranno dal comportamento sicuro anche quando funzionalità e convenienza non sono parte dell’equazione.

Se i dipendenti violano la policy una volta e non ci sono conseguenze negative, lo fanno di nuovo.

Tutto questo senza nemmeno prendere in considerazione le altre questioni legate agli attuali metodi di formazione, che abbiamo discusso altrove.

La maniera più sicura di prevenire il rischio, quindi, è eliminare l’utente dall’equazione. Ma sarebbe come amputare un braccio dolente. Non possiamo separare gli umani dalla tecnologia, o la tecnologia dagli umani, per cui, sebbene in teoria funzionerebbe, in pratica è infattibile.

Quindi la domanda rimane: cosa possiamo fare in merito alle questioni sottese della percezione del rischio e della diffusione della responsabilità (da cui possono derivare molti altri rischi)? In questi casi è necessario aumentare la consapevolezza degli utenti in merito alle tematiche di sicurezza e coinvolgerli attivamente nel processo di sicurezza, senza creare un ambiente paranoico. In breve: dobbiamo progettare formazione e politiche sulla base di come sono gli esseri umani.

Awareness e programmi di formazione sono meccanismi importanti per diffondere la cultura della sicurezza in un’organizzazione. Puntano a stimolare comportamenti sicuri, a motivare gli stakeholder a riconoscere le problematiche di sicurezza, e a educarli a rispondere adeguatamente. Dal momento che l’awareness e la formazione non dipendono solo dai requisiti interni dell’azienda, ma anche dai vincoli esterni, devono essere allineate a tutti i requisiti di compliance. La letteratura e le linee guida attuali del NIST e dell’ENISA al momento enfatizzano l’importanza di allinearsi anche alle necessità di business, all’architettura IT e alla cultura del luogo di lavoro. Il target dei programmi di awareness sono tipicamente i manager anziani, il personale tecnico, i dipendenti e le terze parti (consulenti, fornitori, etc). I programmi di awareness sono essenziali perché le organizzazioni devono assicurarsi che tutti coloro che gravitano loro intorno comprendano e rispettino le politiche e procedure di sicurezza, oltre a seguire le regole specifiche per i sistemi e gli applicativi cui accedono. Ma, come abbiamo spiegato, il comportamento è fortemente influenzato dalle caratteristiche e dai bias personali, il che ha delle conseguenze sul rispetto delle politiche e procedure. Di conseguenza, l’awareness dovrebbe essere progettata per contrastare le convinzioni, i comportamenti e i bias personali.

Quanti progettano i sistemi di sicurezza dovrebbero adottare un approccio sistemico alla formazione, ritenuto una pratica educativa efficace. Al centro di questo approccio è l’identificazione dei bias culturali dei partecipanti, che può facilitare la definizione del fabbisogno e fornire un criterio alternativo di raggruppamento dei partecipanti ai programmi. Poiché i bias culturali dei singoli influenzano la loro percezione e la capacità di prendere decisioni, possono influire anche sul risk assessment svolto da ciascuno di loro. Questo non viene preso in considerazione negli attuali corsi di formazione, il che rende immensamente problematico il modo in cui poi, a corso concluso, i singoli dipendenti archiviano quanto appreso. Se l’insegnamento non viene inquadrato in un adeguato contesto culturale (concetto che può assumere diverse sfumature), i dipendenti non capiranno perché la sicurezza è così importante.

Fortunatamente, inquadrare la sicurezza informatica alla luce dei bias culturali non richiede particolari risorse addizionali. Per esempio, mentre la tecnologia dà priorità alla praticità, in molti casi gli utenti potrebbero trovare più importante l’estetica. I dipendenti potrebbero quindi scegliere la sicurezza rispetto alla praticità, è sufficiente far loro capire perché dovrebbero farlo. Capire da dove provengono i partecipanti ai corsi (per esempio, per il lavoro che svolgono è più importante la praticità, la collaborazione, la velocità, etc.) consente di posizionare sotto la giusta luce la rilevanza della sicurezza. Per esempio, un team che lavora nel campo legale potrebbe comprendere meglio la sicurezza all’interno di un quadro di rischio evitato, mentre il gruppo dei contabili capirebbe meglio le sfumature legate alla confidenzialità, integrità e autenticità del dato. Ecco perché è essenziale progettare le politiche di sicurezza tenendo presenti i bias culturali. E oltre a creare e selezionare materiale di studio di questo tipo, è importante anche creare una solida cultura della sicurezza aziendale.

Sulla stessa falsariga, le aziende dovrebbero creare un sistema concreto di feedback durante e dopo i corsi di aggiornamento: un sistema di feedback debole (quello in cui in cui le scelte pro-sicurezza non ottengono alcuna ricompensa visibile, a parte il complimentoso “congratulazioni, non ti hanno hackerato!”) non spinge o incentiva i dipendenti ad adottare comportamenti sicuri. Durante la formazione, lo strumento più efficace sono le “storie di successo” in cui i controlli di sicurezza hanno prevenuto un incidente, un comportamento intelligente ha bloccato un attacco di social engineering, e una chiara politica di reporting ha limitato e contenuto un’infrazione. Dopo la formazione, sottolineare in maniera casuale il buon comportamento degli impiegati aiuta a consolidare il sistema di feedback (usare rinforzi positivi intermittenti aiuta anche a condizionare i comportamenti).

Svolgere simulazioni e ludicizzazioni durante la formazione rinforzerà ulteriormente il sistema. Ogni volta che possiamo collegare un comportamento sicuro a una ricompensa più alta – anche se in un ambiente simulato – stiamo plasmando comportamenti più sicuri nell’ambiente di lavoro. Se i dipendenti sperimentano l’importanza di controllare una mail durante una simulazione (per prevenire, ad esempio, un attacco di phishing da un concorrente estero), è più probabile che saranno propensi a farlo anche nella vita reale. Perché la presa di coscienza e l’applicazione pratica, come detto, sono incredibilmente importanti per la memorizzazione dell’informazione e la ri-applicazione pratica.

Strettamente legata al sistema concreto di feedback è la correlazione positiva. Le ricerche sui bias cognitivi hanno dimostrato che la capacità di giudizio individuale subisce conseguenze dall’esposizione a stimoli positivi o negativi (per esempio, la vista di volti sorridenti o corrucciati), che coloro che si occupano di scienze decisionali chiamano affect bias, la nostra rapida reazione emozionale a qualcosa. Ne deriva che associare i messaggi sulla sicurezza a delle immagini positive (per esempio, più clienti felici significa più profitto) è un modo efficace di assicurarsi che gli utenti si adeguino alle vostre politiche di sicurezza. Anche ricompensare le buone performance nei test di sicurezza (siano questi programmati o no) aiuta a raggiungere questo obiettivo.

Il bias di ancoraggio, vale a dire la nostra tendenza a fare riferimento alla prima parte di informazione fornita su un argomento, ugualmente influenza il nostro atteggiamento verso le nuove pratiche di sicurezza. Se ai dipendenti viene detto che una password robusta è composta di almeno sei caratteri, con ogni probabilità creeranno password da sei caratteri, non si allontaneranno da questa informazione iniziale. Questo comporta conseguenze a partire dal controllo delle email fino alla navigazione online. Allo stesso tempo, siamo suscettibili al bias di frequenza, per cui diamo priorità ai temi su cui abbiamo più informazioni, e all’effetto recency, per cui diamo priorità ai temi che abbiamo studiato più di recente. Se a un utente vengono impartite cinque ore di lezione sulla creazione della password ma solo tre sugli attacchi di phishing, sarà più attento al primo che non al secondo, sebbene il secondo sia una minaccia più grave e complessa.

Poiché il nostro cervello è fortemente condizionato dall’ordine e dalla frequenza con cui ci vengono presentate le informazioni, dobbiamo progettare delle politiche di sicurezza che tengano conto di queste tendenze. Progettando per il bias di ancoraggio dovremmo presentare subito le pratiche di sicurezza migliori quando affrontiamo un argomento (le password devono essere di 12 caratteri anziché di 6); per il bias di frequenza, dobbiamo assolutamente bilanciare il tempo dedicato a un tema rispetto alla sua importanza (dedicare gran parte del tempo al social engineering); per l’effetto recency, infine, dovremmo concludere i corsi di aggiornamento parlando delle cose più importanti.

Continuando con l’ordine e la cronologia delle informazioni: gli esseri umani tendono ad attribuire maggior valore ai costi e benefici a breve termine che non a quelli a lungo termine. In altre parole, gli esperti di sicurezza dovrebbero sottolineare non solo i benefici a lungo termine e di macro livello di un comportamento sicuro (per esempio, una crescita migliore dell’azienda), ma anche i benefici immediati. Basta guardare le notizie per vedere una pletora di esempi utili, dall’evitare colossali perdite di denaro al prevenire un incubo per l’ufficio PR e Legale. Il pensiero dei costi immediati è efficace su noi umani.

Abbiamo già parlato dei rinforzi positivi, ma è altrettanto importante (ovviamente) punire le violazioni di sicurezza. Avere una politica aziendale non controllata o applicata è l’equivalente dell’avere leggi ma non avere un corpo di polizia. Le aziende devono controllare il comportamento dei dipendenti, oltre al comportamento di coloro che controllano – e prendere provvedimenti quando vengono infrante le regole. Questo si ricollega al sistema concreto di feedback e all’idea che le persone prestino più attenzione all’effetto immediato delle nostre azioni: il miglior deterrente contro l’infrazione delle regole non è la severità delle conseguenze, ma il rischio di essere scoperti.

Un’ultima considerazione cui badare è come ridurre il costo umano dell’implementazione della sicurezza. Questo ricomprende molte delle idee di cui abbiamo discusso fin qui, dalla sicurezza di default alla progettazione efficace della formazione, alla contestualizzazione delle questioni di sicurezza, e al mondo in cui indirizzare correttamente il fattore umano.

La valutazione dei programmi di formazione è necessaria per verificare che siano efficaci. Per valutare un programma, devono essere tenute in considerazione metriche quali la memorizzazione delle informazioni apprese e loro usabilità. Se un programma di formazione si rivela inefficace, deve essere svolto un nuovo assessment sul fabbisogno aziendale e dovrebbero essere prese in considerazione nuove tecniche educative.

La valutazione dei programmi di formazione è necessaria per verificare che siano efficaci. Per valutare un programma, devono essere tenute in considerazione metriche quali la memorizzazione delle informazioni apprese e loro usabilità. Se un programma di formazione si rivela inefficace, deve essere svolto un nuovo assessment sul fabbisogno aziendale e dovrebbero essere prese in considerazione nuove tecniche educative.

Sfortunatamente, tutte le precedenti tecniche da sole non sono sufficienti a vincere la battaglia; nonostante il titolo del nostro pezzo, presumere di essere “vittoriosi” nel più pieno senso del termine sarebbe illusorio. La sicurezza deve diventare un obiettivo strategico a livello nazionale. Richiede un approccio olistico dai governi, dai politici, dagli esperti del settore fino ai cittadini, consumatori e studenti. I programmi di formazione devono essere progettati per arrivare al cuore della nostra società e dovrebbero diventare parte integrante del sistema educativo. I curricula non dovrebbero concentrarsi solo sulle capacità di programmazione o di conoscenza tecnica, ma anche sulle conoscenze di sicurezza: dobbiamo costruire un lessico di sicurezza e un framework condiviso per comprendere il comportamento nella sfera virtuale. E c’è ancora molto da fare.

Conclusioni

Peggy Ertmer sostiene che cambiare le abitudini è una cosa molto complessa, ma che può essere ottenuta attraverso l’esercizio, il supporto culturale e il cambiamento delle convinzioni all’interno della società. C’è ancora un lungo cammino da fare per arrivare a ottenere un ambiente cyber sicuro, come nel mito di Ercole e della virtù: stretto e pieno di ostacoli all’inizio, ma ampio e arioso alla fine. Nell’ambiente militare si dice che se vuoi la pace, devi preparare la guerra.

Quello che dobbiamo fare è considerare questo articolo e le idee qui contenute nella loro interezza. Se vogliamo cambiare la cultura della sicurezza nella nostra società, dobbiamo, come dice la D.ssa Mary Aiken, fermarci, disconnetterci e riflettere. Dobbiamo ricordare l’essere umano.

Anastasios Arampatzis (AKMI Educational Institute)

Justin Sherman (Duke University)