ETICA DIGITALE E INTELLIGENZA ARTIFICIALE. I RISCHI PER LA PROTEZIONE DATI.

Intervista VIP a Fabio Lazzini

Lo sviluppo dell’IA è al centro dell’attenzione non solo degli studiosi, ma dell’intera società. A detta di molti osservatori siamo alla vigilia di un’ulteriore rivoluzione che riguarda il nostro modo di vivere la contemporaneità. Ne parliamo con Fabio Lazzini, ingegnere delle telecomunicazioni, esperto di sicurezza delle informazioni, DPO di Soegi SPA, che ha pubblicato per l’editore Giappichelli, Etica digitale e Intelligenza Artificiale.

Ingegnere l’innovazione tecnologica sta cambiando i nostri asset di riferimento. Orientarsi non è facile, cosa consiglia di fare nel suo studio che sta suscitando un ampio dibattito non solo nella stretta cerchia degli addetti ai lavori?

La rivoluzione dell’intelligenza artificiale è la diretta conseguenza della continua evoluzione del genere umano, alla continua ricerca di un miglioramento delle condizioni di vita. Le sfide che ci attendono sono diversificate così come innumerevoli le aree di applicazione: dalla ricerca scientifica, all’informatica, alla robotica alla medicina sino al mercato azionario. Dobbiamo infatti pensare che la capacità dei computer di elaborare volumi enormi di dati anche in lingue diverse permette agevolmente di interpretare i dati al fine di ottenere i migliori risultati in ogni settore. L’esempio del settore automobilistico dove lo sviluppo dell’intelligenza artificiale è sotto gli occhi di tutti, rende molto bene la portata dei cambiamenti in atto. Le auto dotate di un sistema di giuda senza conducente sono di già una realtà, e con gradi di sicurezza sempre più elevati per la presenza di sensori e telecamere in grado di capire cosa succede durante la guida, prendere decisioni, effettuare manovre per evitare gli ostacoli.

In un futuro vicino queste automobili probabilmente diventeranno il nostro mezzo di trasporto principale. L’intelligenza artificiale ci permette, inoltre, di generare testi, tradurre lingue e interpretare un discorso, si pensi agli assistenti digitali come ad esempio Alexa o Siri, che sono già presenti nelle nostre case, così come la domotica cablata e il wireless sempre più alla portata di tutti, caratterizzati da servizi in cloud e dall’uso crescente dell’IA. Oppure agli strumenti di riconoscimento vocale che utilizziamo con i sistemi di sicurezza o con gli smartphone: molti presentano piattaforme basate su sistemi di IA che permettono una vera e propria interazione tra il telefono e il suo possessore. La sfida futura risiede nella capacità nostra di gestire tutte queste trasformazioni ad oggi positive, e far sì che tutta questa tecnologia non ci si ritorca contro.

Nel saggio si parla di un “contesto etico” che va rafforzato e difeso. Quali strategie vanno adottate?

Ad oggi non conosciamo una definizione univoca di intelligenza artificiale. Quello che ci è dato conoscere è il fatto che la macchina è in grado di compiere in modo automatico e in piena autonomia un compito, che si esplica nella caratteristica propria di elaborare una quantità di dati, in un processo continuo di aggregazione e disaggregazione degli stessi. Il tutto a una velocità incomprensibile per l’uomo, secondo una particolare formula preconfezionata il c.d. algoritmo. Diventa così centrale la problematica relativa ai dati che vengono elaborati da macchine sempre più sofisticate in grado di apprendere autonomamente, (si parla non a caso di machine learning n.d.r.) o persino di sviluppare nuovi percorsi di acquisizione come nel caso del deep learning.

Se questo è possibile da realizzare per la macchina è invece difficile poter calcolare le numerose variabili impreviste e imprevedibili, cioè il discernimento. Quest’ultima è una caratteristica tipicamente umana così come propriamente umana è la capacità di esprimere emozioni, pensieri, attitudini e preferenze. Sarà dunque sempre più necessario porsi delle domande in merito al diritto e all’etica dell’algoritmo. Sarà quindi compito dell’uomo, del legislatore esaminare e sorvegliare i processi evolutivi dell’IA, affinché le enormi capacità della macchina siano sempre utilizzate in modo saggio per la stessa sopravvivenza della specie. Su questa linea si sta muovendo l’Unione Europea stillando delle linee giuda etiche nell’utilizzo della IA.

Governance giuridica e sviluppo della tecno-scienza

A proposito di regole, quale governance giuridica andrà pensata per strumenti potenti come l’intelligenza artificiale?

In un contesto di tecnologie sempre più traccianti, profilanti e predittive diventa sempre più necessario apportare strumenti in grado di tutelare gli individui, dalla violazione dei diritti dei dati personali. Questa esigenza è ancor più necessaria in vista della tutela degli individui dagli usi potenzialmente scorretti delle neurotecnologie, in grado di condizionare il pensiero e l’agire umano. Si parla di neurodiritti, categoria di diritti umani attinenti alla sfera mentale e neurocognitiva. Si tratterebbe di una rivoluzione neurotecnologica, che crea nuovi contorni che sfuggono all’attuale quadro normativo vigente. La più comune delle neurotecnologie è l’elettroencefalografia una tecnica di registrazione elettrica del cervello, che è la più comune tecnica di monitoraggio in tempo reale dell’attività funzionale del cervello. Questa sarebbe in grado di condizionare il pensiero e addirittura l’agire: la cosiddetta interfaccia cervello-macchina, un canale di comunicazione diretta tra cervello e computer.

Di neurodiritti ha parlato recentemente Pasquale Stanzione, Presidente dell’Autorità Garante per la Protezione dei dati Personali, il suo saggio Ginevra Cerrina Feroni, si apre con la prefazione della giurista Ginevra Cerrina Feroni che fa parte della stessa Authority che sottolinea il ruolo del GDPR nell’evoluzione del delicato binomio: scienze giuridiche – evoluzione tecnologica. Cosa dobbiamo aspettarci su questo delicato fronte?

Diventa sempre più attuale la necessità di proteggere l’individuo dal pericolo di un uso scorretto di queste tecniche. L’attenzione del Garante non è solo opportuna, direi necessaria, in un quadro socio-tecnologico così in divenire. Attorno ai neurodiritti è importante che venga definito uno statuto giuridico ed etico, in base a cui coniugare l’innovazione con la dignità della persona. Il rischio, altrimenti, è che innovazioni scientifiche potenzialmente preziose per la cura di stati neurodegenerativi divengano lo strumento per fare dell’uomo una non-persona, da addestrare o classificare, normalizzare o escludere.

“Algrograzia” e “algoretica” ambiti delicati e ancora poco conosciuti. Può dirci qualcosa in più in merito?

Algocrazia significa letteralmente “potere degli algoritmi”, tutti noi siamo ormai circondati dalle più avanzate tecnologie, sia di informazione che di intelligenza artificiale. Queste, infatti, hanno assunto un peso sempre più rilevante nella società e nell’economia globale. e spaziano in settori molto diversi tra loro, che vanno dalla sanità, all’istruzione, alla giustizia, fino a toccare persino la politica. Tutta la nostra quotidianità è intrisa di tecnologia, si pensi agli assistenti vocali, al riconoscimento facciale, presenti nelle fotocamere dei nostri dispositivi o sui social network, strumenti tutti invisibili nell’interfaccia di app e programmi, che usiamo giornalmente senza neppure rendercene conto. Si basano su algoritmi anche le transazioni finanziarie e le geolocalizzazioni, i motori di ricerca dei nostri computer, la prenotazione di un posto in aereo o in treno, la firma elettronica. Tutto è basato su algoritmi e le prospettive di sviluppo futuro sono inimmaginabili.

Algocrazia significa letteralmente “potere degli algoritmi”, tutti noi siamo ormai circondati dalle più avanzate tecnologie, sia di informazione che di intelligenza artificiale. Queste, infatti, hanno assunto un peso sempre più rilevante nella società e nell’economia globale. e spaziano in settori molto diversi tra loro, che vanno dalla sanità, all’istruzione, alla giustizia, fino a toccare persino la politica. Tutta la nostra quotidianità è intrisa di tecnologia, si pensi agli assistenti vocali, al riconoscimento facciale, presenti nelle fotocamere dei nostri dispositivi o sui social network, strumenti tutti invisibili nell’interfaccia di app e programmi, che usiamo giornalmente senza neppure rendercene conto. Si basano su algoritmi anche le transazioni finanziarie e le geolocalizzazioni, i motori di ricerca dei nostri computer, la prenotazione di un posto in aereo o in treno, la firma elettronica. Tutto è basato su algoritmi e le prospettive di sviluppo futuro sono inimmaginabili.

Ed è qui che entra l’algoretica?

Certamente perché tutta questa tecnologia di cui abbiamo parlato bisogna saperla governare ed indirizzare, affinché non diventi volano di discriminazioni, fino a tramutarsi in una dittatura dell’algoritmo. L’algoritmo deve, per capirci, prestarsi (uso un termine per semplificare) a una dimensione etica che non significa che dei valori possano essere inseriti nelle logiche algoritmiche, caratteristiche proprie solo dell’uomo, ma prevedere e programmare dei sistemi in grado di orientare la macchina, consentendo di misurare il rischio che le cose possano andare in una direzione sbagliata, ciò vuol dire ledere il diritto o la dignità dell’individuo.

Un terreno delicato, difficile da praticare per chiunque, non crede?

Proprio per questo occorre codificare principi e norme, ripeto, etiche capaci di agire dentro la macchina. Questa è la sfida che dobbiamo portare avanti, affinché quella delle IA sia davvero una rivoluzione che porta a un autentico sviluppo, e l’etica possa accompagnare questo straordinario sviluppo della scienza e della tecnologia che sta segnando questo cambiamento d’epoca.

La figura del DPO nella società dell’informazione

Come si definisce il ruolo del DPO, figura che assumendo una valenza importante, mentre nelle aziende si sta assistendo a una ridefinizione di profili, competenze, assetti organizzativi?

Il Regolamento (UE) 2016/679 fornisce un rilevante contributo alla tutela dell’individuo e dei propri diritti fondamentali all’interno del nuovo mondo digitale. In questo contesto la figura del DPO assume un ruolo di primo piano, contribuendo a salvaguardare le libertà e la dignità degli individui – nell’utilizzo di processi decisionali automatizzati – da potenziali trattamenti discriminatori connessi all’illusoria neutralità degli algoritmi e a un uso distorto e non etico dell’Intelligenza Artificiale. Tale impostazione, per altro, risulta coerente con i principi di trasparenza e di accountability che permeano l’intero Regolamento, assicurando una maggiore visibilità dell’algoritmo e favorendo l’appello delle decisioni da parte dei soggetti direttamente interessati dal processo automatizzato.

Il DPO come figura di controllo può altresì contribuire monitorare le regole e le logiche attraverso cui vengono implementati gli algoritmi che incidono sulle nostre vite consigliando che prima dell’esecuzione di un’attività di trattamento ne venga accertata la conformità ai valori etici e sociali condivisi anche attraverso una DPIA in modo da responsabilizzare i titolari e i responsabili circa le potenziali conseguenze etiche e sociali derivanti dall’utilizzo dei dati.

Il DPO come figura di controllo può altresì contribuire monitorare le regole e le logiche attraverso cui vengono implementati gli algoritmi che incidono sulle nostre vite consigliando che prima dell’esecuzione di un’attività di trattamento ne venga accertata la conformità ai valori etici e sociali condivisi anche attraverso una DPIA in modo da responsabilizzare i titolari e i responsabili circa le potenziali conseguenze etiche e sociali derivanti dall’utilizzo dei dati.

Vi è anche un interessante processo di ridefinizione delle responsabilità nell’impresa di oggi che deve essere preso in esame. Siamo pronti al riguardo?

Siamo sulla strada giusta. Rimanendo sull’analisi del DPO, va aggiunto che con il suo apporto garantisce una conformità normativa e un approccio aziendale etico e completo alla gestione del rischio IA migliorandone la fiducia nell’utilizzo. Per questo ritengo che all’interno delle organizzazioni sia necessario istruire comitati ad hoc per assumere le responsabilità chiare legate al rischio IA di cui il DPO deve essere parte attiva ed integrante. L’IA può essere inoltre utilizzata nell’ambito di protezione dati per le attività di audit e assessment sull’attuazione dei controlli di privacy e sicurezza facilitando l’analisi e la gestione di un eventuale data breach. La digitalizzazione dei controlli tramite l’intelligenza artificiale rende, infatti, possibile la condivisione degli obiettivi e le risultanze. Portando di fatto all’integrazione di diverse funzionalità e rendendo così più efficiente il processo.

Qual è il livello di consapevolezza che la società ha maturato sul livello rischio che la “potenza della tecnica” per sua stessa natura implica?

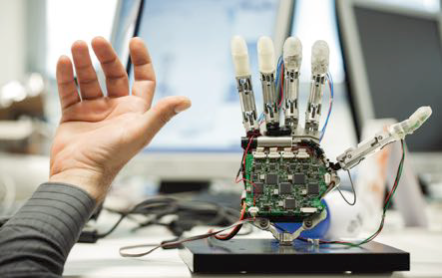

Stefano Rodotà parlò per la prima volta in Italia di “corpo elettronico” vent’anni fa. Il grande giurista s’interrogava sulle trasformazioni di un’identità umana che vivesse la realtà attraverso un corpo dotato di potenziamenti tecnologici applicati direttamente su di esso. Oggi tutto questo è diventato realtà, basti pensare ai dispositivi posti sui telefoni cellulari in grado di rilevare lo stato di salute generale della persona, e la possibilità di condividere tutto quanto col proprio medico curante e perché no, anche con l’assicuratore.

La biorobotica attraverso sofisticati dispositivi è in grado di creare braccia che possono sollevare pesi impensabili fino a poco tempo fa, oppure ai microchip che rendono superflui la carta d’identità o agli indumenti intelligenti che ci dicono come vestirsi a seconda dell’ambiente circostante. Il nostro corpo non è più materiale, ma diventa un insieme di dati sparsi in una molteplicità di banche dati, con profili che su queste basi vengono costruiti. La nostra conoscenza si sposta in un territorio nuovo. Questo mutamento di orizzonte incide sull’eguaglianza, sulla libertà di comunicazione, di espressione e circolazione, sul diritto alla salute. Dal principio giuridico dell’habeas corpus su cui si è per secoli fondata la libertà personale, siamo proiettati nell’area di pertinenza dell’habeas data. Si passa dalla tutela dell’integrità della persona alla tutela del corpo elettronico, considerando alla stregua di quello fisico, ed estendendo ad esso, con le dovute differenze, le medesime tutele. Emergono in questa dimensione profili “inediti” di responsabilità, perché anche il corpo elettronico ha un’anima che fa parte della nostra identità più intima e segreta.

Un capitolo del libro è dedicato allo sviluppo della cyber security. Quali strategie vanno messe in atto in questo delicato ambito che vede in particolare i minori particolarmente esposti?

Lo sviluppo crescente della tecnologia ha esposto qualsiasi azienda come ogni persona, alle minacce che provengono dalla rete internet. Gli attacchi informatici in Italia, così come nel resto del mondo, sono in forte crescita e la cyber security si trova di fronte a una minaccia persistente dovuta ai continui tentativi di penetrare la sicurezza aziendale da parte di malware, phishing, sociale engineering e altre tipologie di attacchi informatici. L’entrata in vigore del GDPR ha inciso in materia importante sugli investimenti nella sicurezza informatica, mettendo in evidenza quanto sia importante per le aziende che operano nel settore mantenere livelli di sicurezza adeguati per le informazioni, le quali costituiscono un valore da difendere. Tocca però ai vertici aziendali valutare quali sono i rischi che possono verificarsi in materia di privacy di dati e informazioni e, quali sono le contromisure adeguate da prendere tenendo conto che la gestione della cyber security varia in base alle esigenze e alla struttura di ogni organizzazione.

I rischi presenti sulla rete sono infatti molteplici, specialmente quando a subirli sono i minori, che possono essere vittime inconsapevoli di veri e propri reati, che vanno dall’adescamento dei minori, reato punibile penalmente, ai pericoli in caso di giochi pericolosi col rischio di emulazione. Basti pensare al caso più diffuso dei c.d. selfie estremi, ossia gli autoscatti fatti in luoghi pericolosi o al problema dell’accesso dei minori a contenuti non adatti alla loro età. Molte son o a tal fine, le strategie poste in campo dai fornitori per la tutela di questi fenomeni che hanno subito ultimamente una crescita esponenziale. Si va dalla predisposizione agli utenti dei c.d. sistemi di parental control ovvero di filtro di contenuti inappropriati per i minori e di blocco di contenuti riservati ad un pubblico di età superiore agli anni diciotto. Ricordiamoci però che risulterà di importanza decisiva fondare la gestione di tali meccanismi su principi di chiarezza e trasparenza delle informazioni, nonché di semplicità e intuitività, in modo tale da dare a tutti la possibilità di metterli in pratica. Molto comunque c’è molto ancora da fare. La “sicurezza informatica” è un valore che riguardare tutti noi, nessuno può chiamarsi più fuori, siamo tutti coinvolti nella costruzione di una civiltà digitale che possa essere degna di questo nome.

Autore: Massimiliano Cannata