Sempre più insistentemente si parla di Cyber Exposure e di Attack Surface Management, come se fossero concetti nuovi, mai affrontati in precedenza. In realtà, i responsabili di sicurezza hanno ben chiaro in mente il loro significato e l’importanza di questi concetti per la Security Posture. Quello che si nota negli ultimi mesi, però, è un aumento della difficoltà di gestione di queste problematiche, anche da parte di chi è già abituato da tempo a doverle fronteggiare.

Questo trend era, dunque, presente anche nel recente passato, ma i cambiamenti delle abitudini lavorative degli ultimi mesi hanno determinato un notevole mutamento dei loro contenuti e delle attività correlate. Satya Nadela, il CEO di Microsoft scrisse nell’ormai “lontanissimo” Aprile del 2020 di aver vissuto “2 years of digital transformation in 2 months”1 . Oggi, a un anno e mezzo di distanza, il vecchio concetto di Attack Surface Management risulta, quindi, ormai definitivamente obsoleto. Shilpi Handa, nell’articolo “The Essential Elements of Effective Vulnerability Management”2 pubblicato da Gartner nell’ottobre 2020, spiega bene cosa sia cambiato per le varie organizzazioni: la maggior parte delle aziende dispone ormai di complesse interconnessioni tra server, istanze cloud, desktop, laptop, dispositivi mobili, Internet of Things (IoT) e altro ancora, cioè di una rete di difficile monitoraggio di risorse dinamiche, in continuo movimento, e spesso delocalizzate.

Questo trend era, dunque, presente anche nel recente passato, ma i cambiamenti delle abitudini lavorative degli ultimi mesi hanno determinato un notevole mutamento dei loro contenuti e delle attività correlate. Satya Nadela, il CEO di Microsoft scrisse nell’ormai “lontanissimo” Aprile del 2020 di aver vissuto “2 years of digital transformation in 2 months”1 . Oggi, a un anno e mezzo di distanza, il vecchio concetto di Attack Surface Management risulta, quindi, ormai definitivamente obsoleto. Shilpi Handa, nell’articolo “The Essential Elements of Effective Vulnerability Management”2 pubblicato da Gartner nell’ottobre 2020, spiega bene cosa sia cambiato per le varie organizzazioni: la maggior parte delle aziende dispone ormai di complesse interconnessioni tra server, istanze cloud, desktop, laptop, dispositivi mobili, Internet of Things (IoT) e altro ancora, cioè di una rete di difficile monitoraggio di risorse dinamiche, in continuo movimento, e spesso delocalizzate.

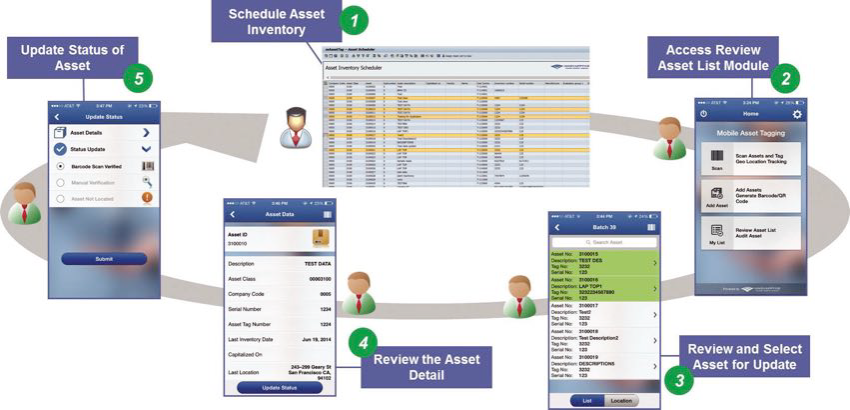

Tutto ciò, ovviamente, ha determinato un aumento del rischio di esposizione a minacce esterne all’organizzazione. Mantenere un inventario accurato delle risorse è quindi fondamentale per qualsiasi solido programma di sicurezza informatica. Altrettanto fondamentale la necessità di estendere il Vulnerability Management anche a questo inventario. Digital transformation e Asset Inventory sono, quindi, le tematiche da cui partire per comprendere le nuove problematiche in ambito di Cyber Exposure. La Digital Transformation ha cambiato profondamente e molto velocemente il modo in cui le organizzazioni si espongono all’esterno (Cyber Exposure) e i meccanismi finora utilizzati per la gestione di questo rischio, tra cui i processi e le soluzioni di Inventory Management e di Vulnerability Management, non sempre sono riusciti ad adattarsi con la stessa velocità.

Cosa è cambiato all’interno e all’esterno delle organizzazioni?

Cosa è cambiato all’interno e all’esterno delle organizzazioni?

Come ben sappiamo le organizzazioni sono state costrette ad accelerare i propri progetti di Digital Transformation e il movimento verso il cloud ha senz’altro guidato questo trend. Ciò ha comportato nuove problematiche per la Cyber Security:

- Come mantenere aggiornato in tempo reale il proprio inventario delle istanze cloud.

- Come applicare i controlli e le policy di sicurezza in queste istanze.

- Come rilevare nuovi asset, non solo nel cloud, creati al di fuori degli account preposti.

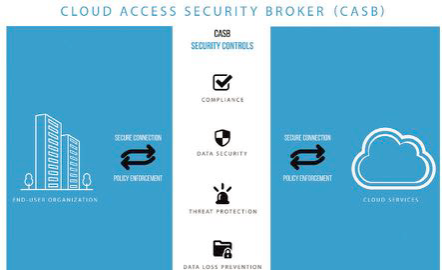

Per fronteggiare tali problematiche sono emerse diverse soluzioni di cloud security suddivise da Gartner in 3 grandi macro-soluzioni:

Per fronteggiare tali problematiche sono emerse diverse soluzioni di cloud security suddivise da Gartner in 3 grandi macro-soluzioni:

- CASB (Cloud Access Security Broker), la cui implementazione è strettamente correlata all’istituzione di policy di governance e rappresenta un buon su cloud, ma non sufficienti ad identificare le infrastrutture IT nascoste (es. istanze cloud di sviluppo e collaudo)

- CPSM (Cloud Security Posture Management) in grado di monitorare se i dipendenti aderiscono alle policy, ma solo per le istanze cloud note.

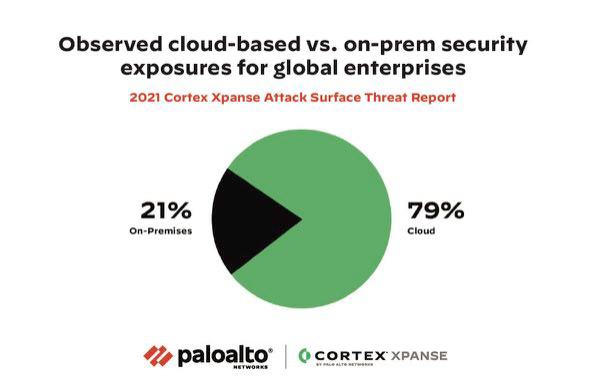

Queste soluzioni hanno come limite di agire esclusivamente su quanto è noto a priori. Il processo di Cloudification, tuttavia, non è l’unico trend a impattare sulla Cyber Exposure, anche se è da solo responsabile del 79% dei problemi più critici riscontrati. Bisogna infatti considerare anche che, con la massiva e improvvisa adozione dello Smart Working, molte risorse aziendali, pensate per lavorare in reti interne, sono entrate nel perimetro della Cyber Exposure.

Queste soluzioni hanno come limite di agire esclusivamente su quanto è noto a priori. Il processo di Cloudification, tuttavia, non è l’unico trend a impattare sulla Cyber Exposure, anche se è da solo responsabile del 79% dei problemi più critici riscontrati. Bisogna infatti considerare anche che, con la massiva e improvvisa adozione dello Smart Working, molte risorse aziendali, pensate per lavorare in reti interne, sono entrate nel perimetro della Cyber Exposure.

A livello aziendale si assiste inoltre a un proliferare di servizi esternalizzati, o comunque non gestiti direttamente dalla IT, distribuiti su diversi provider di hosting. La Cybersecurity deve esserne a conoscenza, in modo da gestirli e soprattutto adeguarli agli standard di conformità e sicurezza. Governare la propria Supply Chain è quindi un altro aspetto da considerare, e poco importa che si tratti di asset gestiti da terze parti o meno, le aziende devono ora tenerne obbligatoriamente conto. Nell’immaginario collettivo, tutte le organizzazioni hanno piena conoscenza della propria struttura IT, ma a causa di questi trend ciò non corrisponde necessariamente al vero.

I team di sicurezza devono applicare standard e policy di governance anche a risorse che non vedono e non sanno di possedere. In termini di sicurezza, questo si traduce nel peggior incubo di un CISO: una superficie di attacco effimera che in caso di violazione costringe ad ammettere davanti al consiglio di amministrazione che non si era a conoscenza delle risorse compromesse.

I team di sicurezza devono applicare standard e policy di governance anche a risorse che non vedono e non sanno di possedere. In termini di sicurezza, questo si traduce nel peggior incubo di un CISO: una superficie di attacco effimera che in caso di violazione costringe ad ammettere davanti al consiglio di amministrazione che non si era a conoscenza delle risorse compromesse.

Secondo le nostre analisi, anche le organizzazioni con programmi di vulnerability management estremamente maturi sono in grado di identificare solo l’80% circa della propria superficie di attacco. Se da un lato il contesto in cui ci troviamo ad operare ha reso sempre più compless

o e difficile per le aziende tenere sotto controllo il proprio perimetro, dall’altro ha reso più semplice ed economico per gli hacker ricercare e sfruttare le vulnerabilità.

Le risorse computazionali sono diventate così poco costose che oggi basta spendere circa $10 per affittare la potenza del cloud computing necessaria per effettuare una scansione dell’intero Internet alla ricerca di sistemi vulnerabili. Da analisi e rilevazioni effettuate dal team Cortex Xpanse di Palo Alto Networks, si osserva che in una giornata tipo gli hacker effettuano scansioni una volta ogni ora, mentre le aziende più organizzate possono impiegare anche settimane. L’assioma per cui la sicurezza di un’infrastruttura equivale a quella del suo anello più debole è sempre valido e gli attaccanti sono alla costante ricerca di questo anello.

Un esempio eloquente è quanto visto accadere subito dopo la pubblicazione della vulnerabilità Zero-day relativa a Microsoft Exchange annunciata il 2 Marzo 2021 da Microsoft: in quel caso gli attaccanti hanno avviato delle scansioni entro cinque minuti dall’annuncio. Situazioni analoghe si presentano mediamente ogni 12 ore, non necessariamente legate a zero-day ma anche a problemi di configurazione, ad accessi remoti non sicuri (RDP, Telnet, SNMP, VNC, ecc.) o a servizi che non dovrebbero essere esposti (Database, SNMP, interfacce di amministrazione, IoT, ambienti di sviluppo, ecc.). Vivere con un nuovo problema ogni 12 ore evidenzia la natura effimera dell’IT di oggi.

Quanto conta essere proattivi?

Diventa quindi fondamentale introdurre un nuovo KPI denominato MTTI – Mean Time to Inventory. MTTI misura il tempo necessario alle organizzazioni per eseguire un inventario completo delle risorse, esterne e interne, e assegnare ad esse una classificazione basata sulla criticità. MTTI diventa particolarmente critico quando viene annunciato un nuovo CVE. Le organizzazioni utilizzano già metriche simili per misurare l’efficacia della propria sicurezza informatica come, per esempio, il tempo di permanenza (Dwell Time), il tempo medio di rilevamento (MTTD) o tempo medio di risposta (MTTR). Tuttavia, queste misurazioni sono di natura intrinsecamente reattiva e concentrate di conseguenza solo su asset già conosciuti e oggetto di un incidente informatico. La domanda da cui partire diventa quindi: come facciamo a proteggere qualcosa che non sappiamo di avere? La questione non è puramente teorica, ma reale visto i diversi casi accaduti in cui si evidenzia che la velocità di identificazione sarebbe stata un’efficace garanzia di protezione dalle minacce.

Tra Dicembre 2020 e Febbraio 2021 Accelion ha pubblicato diversi CVE e relative patch per rispondere a una serie di vulnerabilità emerse nella propria soluzione Accelion File Transfer Appliance (FTA). A partire da Febbraio 2021 sono stati resi noti molteplici data breach che hanno sfruttato queste vulnerabilità principalmente da parte del threat actor Clop/FIN113 . Nonostante la soluzione Accellion FTA fosse dichiarata legacy dal produttore era ancora utilizzata attivamente dal 25% dei loro clienti come repository pubblico di dati critici e sensibili.

Anche oggi, dopo diversi mesi, data breach legati a questo problema continuano a emergere. La pubblicazione di sistemi vulnerabili non opportunamente patchati o in EOL è considerato uno dei primi 3 problemi elencati nella ASM Top 10 Exposures4 . A Marzo 2021 Microsoft ha annunciato di aver identificato diverse vulnerabilità presenti sulle versioni di Microsoft Exchange Servers onpremises e di aver riscontrato il loro sfruttamento attraverso exploit di tipo zero-day da parte del threat actor Hafnium5 . Identificare e mettere in sicurezza tutte le istanze pubbliche di Microsoft Exchange Server è diventata la priorità per tutte le aziende e organizzazioni.

Infine a Luglio 2021 Kaseya ha comunicato ai propri clienti che la propria soluzione di remote monitoring e management Kaseya VSA esponeva una vulnerabilità zero day che era stata utilizzata per veicolare ransomware dal famoso gruppo hacker REvil6 . In questo caso gli attaccanti hanno sfruttato una vulnerabilità zero day per bypassare l’interfaccia di autenticazione ed eseguire codice arbitrario sul server Kaseya VSA, di fatto distribuendo agli endpoint il ransomware grazie alle funzionalità di software distribution offerte nativamente dal prodotto. Anche in questo caso, poter avere un immediato riscontro sui propri sistemi Kaseya esposti e quindi sfruttabili per attacchi avrebbe dovuto essere la base per un adeguato piano di protezione.

Da questi esempi si evince che la corsa ad aggiornare tutti i propri sistemi risulta essere una gara persa in partenza, se non si è adeguatamente preparati e organizzati. Oltre al tema noto delle vulnerabilità, bisogna considerare anche la problematica relativa alla pubblicazione di strumenti di accesso remoto non sicuri o adeguatamente protetti, considerati al primo posto nella classifica pubblicata da ASM Top 10 Exposures7.

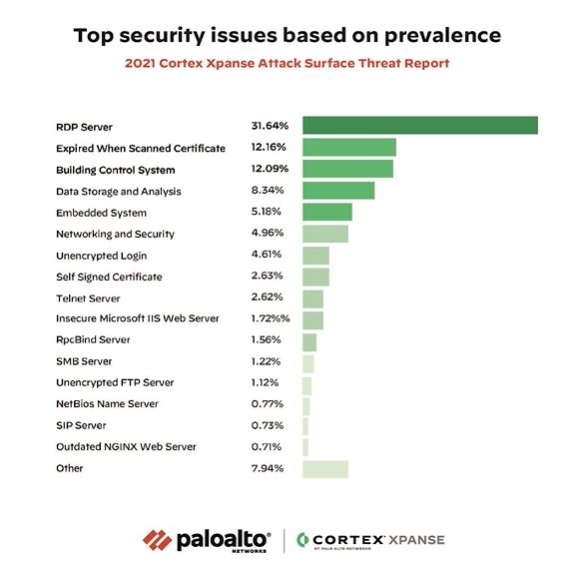

A tal proposito, il protocollo RDP (Remote Desktop Protocol) è considerato il vettore iniziale di attacco ransomware più popolare ed è stato utilizzato per anni. La divisione Unit 42 di Palo Alto Networks ha studiato i dati di oltre 1.000 incidenti e ha scoperto che nel 50% dei casi di distribuzione di ransomware, RDP era il vettore di attacco iniziale8 . Se a ciò aggiungiamo il fatto che l’RDP rappresenta il 30% delle esposizioni totali9 e che, dal primo trimestre 2020 (pre-COVID-19) al secondo trimestre 2020 (post-COVID-19), le esposizioni RDP sono aumentate del 59% tra tutti i fornitori di servizi cloud10, è facile comprendere le motivazioni per cui viene ritenuto così critico.

È estremamente facile, infatti, esporre RDP involontariamente, lasciandolo su un sistema dimenticato, su un istanza cloud, su un dispositivo precedentemente protetto dai firewall aziendali, o collegando il proprio device direttamente a Internet. Lasciare RDP aperto equivale, quindi, a permettere a chiunque di accedere al proprio sistema come se fosse fisicamente di fronte alla tastiera. Essendo tecnicamente possibile scansionare l’intero Internet in soli 45 minuti, se RDP fosse esposto, questo verrebbe tempestivamente trovato da malintenzionati e sottoposto ad attacchi di tipo Credential Theft, Brute Force o Man-in-the-middle. Per questi motivi RDP viene oggi anche simpaticamente chiamato Ransomware Deployment Protocol.

Come affrontare queste nuove sfide?

Oggi più che mai, la maggior parte dei principali obblighi di compliance richiede un requisito fondamentale: mantenere e aggiornare continuamente il proprio inventario delle risorse. Dato il presupposto che, nella migliore delle ipotesi, quelle conosciute rappresentano solo l’80% di ciò che si possiede effettivamente e dato il contesto descritto in continua rapida evoluzione, risulta necessario oggi occuparsi anche e soprattutto delle proprie risorse esposte esternamente. Innanzitutto si deve partire dall’individuazione di ciò che si ha esposto esternamente, creando e tenendo sempre aggiornato un inventario completo che includa:

Oggi più che mai, la maggior parte dei principali obblighi di compliance richiede un requisito fondamentale: mantenere e aggiornare continuamente il proprio inventario delle risorse. Dato il presupposto che, nella migliore delle ipotesi, quelle conosciute rappresentano solo l’80% di ciò che si possiede effettivamente e dato il contesto descritto in continua rapida evoluzione, risulta necessario oggi occuparsi anche e soprattutto delle proprie risorse esposte esternamente. Innanzitutto si deve partire dall’individuazione di ciò che si ha esposto esternamente, creando e tenendo sempre aggiornato un inventario completo che includa:

- Dispositivi IoT e sistemi utilizzati per il remote working, asset che spesso mancano di una protezione di sicurezza sufficiente.

- Infrastrutture cloud, che vengono attivate e disattivate con un ritmo molto rapido.

- Sistemi in gestione a terze parti, di cui è difficile monitorare la compliance.

- Certificati, indirizzi IP, servizi e protocolli di comunicazioni, classificati dagli standard come rischiosi.

Parafrasando il noto detto «Non puoi migliorare ciò che non puoi misurare», e portandolo in un contesto più attinente alla cyber security, si potrebbe dire “Non puoi proteggere ciò che non sai di possedere”: mantenere questo inventario in una moderna infrastruttura tecnologica in continuo cambiamento ed evoluzione è un compito impossibile per un essere umano. Richiede, quindi, un sistema ed un approccio automatizzato, sia per scoprire risorse sconosciute sia per garantire la sicurezza.

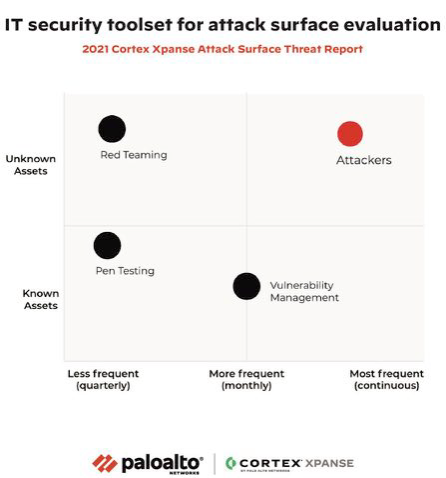

Tradizionalmente, la mappatura delle risorse sulla rete di un’organizzazione è sempre stata un’attività fortemente manuale, soggetta a inevitabili errori, soprattutto se gestita tramite un foglio di calcolo in carico ad IT. D’altra parte, in passato, per scansionare Internet per determinare la struttura e la topologia delle proprie risorse erano necessari mesi. Tutto è cambiato nel 2013: i nuovi algoritmi hanno consentito la scansione globale di Internet a una velocità 1.500 volte più alta rispetto al passato. Oggi, sono necessari meno di 45 minuti per comunicare con ogni singolo IP pubblico nello spazio IPv4 (4,3 miliardi di IP) su una singola coppia porta-protocollo. Per metterlo in prospettiva, il tempo necessario per guardare un episodio della tua serie preferita. Le moderne soluzioni di Attack Surface Management (ASM) tengono conto di tutto ciò per fornire un inventario completo di tutte le risorse (indirizzi IP, domini, certificati, risorse cloud e on-prem) e mappare la responsabilità interna all’organizzazione per ciascuna risorsa. Dato che gli hacker possono scansionare l’intera Internet alla ricerca di sistemi vulnerabili in meno di un’ora, i difensori devono tenere il passo e garantire che il loro tempo medio di inventario (MTTI) sia più veloce di quello degli aggressori.

Non sapendo a priori dove sono gli asset di una azienda, le soluzioni di ASM devono scansionare e analizzare la totalità di internet. La difficoltà e, quindi, il valore della soluzione, diventa la capacità di attribuire una risorsa, magari esposta dietro a un indirizzamento di una adsl domestica, di un fornitore esterno oppure di un cloud provider pubblico, a una specifica organizzazione. Per ottenere questo processo di attribuzione è necessario creare un link tra ogni asset identificato e il relativo proprietario.

Non sapendo a priori dove sono gli asset di una azienda, le soluzioni di ASM devono scansionare e analizzare la totalità di internet. La difficoltà e, quindi, il valore della soluzione, diventa la capacità di attribuire una risorsa, magari esposta dietro a un indirizzamento di una adsl domestica, di un fornitore esterno oppure di un cloud provider pubblico, a una specifica organizzazione. Per ottenere questo processo di attribuzione è necessario creare un link tra ogni asset identificato e il relativo proprietario.

Per fare ciò non è sufficiente basarsi sulla proprietà di uno specifico range di indirizzi IP, ma è necessario analizzare certificati, informazioni, comunicazioni di questi asset e molto altro. Vista l’enormità dei dati da analizzare e le tempistiche strette richieste, si rende quindi necessario l’utilizzo di algoritmi di machine learning ed artificial intelligence a supporto di una corretta e pronta attribuzione. Più in generale, una soluzione di ASM dovrebbe anche supportare il processo di riduzione della superficie di attacco di un’organizzazione, in modo che le risorse possano essere aggiornate, disattivate o segregate da Internet così da non essere più bersaglio degli aggressori. Un corretto processo di ASM dovrebbe iniziare dunque con la scansione dell’intero spazio IPv4 per individuare tutte le risorse connesse alla rete internet e procedere poi con la successiva attribuzione automatica in real time alla specifica azienda.

In caso di individuazione di risorse precedentemente sconosciute, il processo dovrebbe proseguire associando correttamente la risorsa e inviando apposita notifica all’azienda, al team o alla persona individuata come responsabile della protezione di tale risorsa. Lo step successivo e altrettanto fondamentale consiste nel verificare la conformità dell’inventario fin qui rilevato alle policy specifiche di ogni singola azienda e alle best practice di mercato, così da trasformare un semplice elenco di asset in una lista actionable di rischi da gestire. Una volta avuta la corretta visibilità sui rischi rilevati si potrà passare al processo di mitigation degli stessi, sfruttando l’integrazione con soluzioni di SOAR, patch management, vulnerability management, cloud security posture management e quant’altro.

È evidente che avere un corretto processo per la gestione della Cyber Exposure è essenziale, ma è altrettanto essenziale avere gli strumenti adeguati a supporto di tale processo. Un servizio che sia di reale supporto al processo di ASM dovrebbe fornire:

- Un unico repository di informazioni automatizzato e continuamente aggiornato per tutte le risorse connesse a Internet.

- La corretta associazione degli owner a tutte le risorse precedentemente individuate, conosciute e sconosciute.

- Tutte le esposizioni e i relativi rischi.

- L’integrazione con i processi di Incident Response aziendali, automatizzando la risoluzione dei rischi e il reporting degli stessi.

- Il monitoraggio continuo della rete internet per scoprire, valutare e mitigare i rischi man mano che la superficie di attacco cambia.

Palo Alto Networks ha vissuto in prima persona i cambiamenti imposti dalla Digital Transformation e dal Flex Working e si è subito attivata per gestire la propria Cyber Exposure.

All’interno del Security Operation Center questa problematica è dunque ben conosciuta da tempo ed è stata gestita sfruttando l’integrazione tra le soluzioni Cortex XSOAR e Cortex XDR insieme alla soluzione Cortex Xpanse (ex Expanse). Per illustrare il proprio approccio alla problematica, Palo Alto Networks organizza appositi incontri dove è possibile confrontarsi con le funzioni CISO e SOC interne per discutere insieme delle scelte effettuate e delle soluzioni adottate.

Autori: Andrea Rossini, Daniele Nicita

2 https://www.gartner.com/en/documents/3991384/the-essential-elements-of-effective-vulnerabilitymanage

3 https://www.accellion.com/company/press-releases/accellion-provides-update-to-recent-fta-securityincident

4 https://attacksurfacetop10.com/top-ten-exposures

5 https://www.microsoft.com/security/blog/2021/03/02/hafnium-targeting-exchange-servers/

6 https://helpdesk.kaseya.com/hc/en-gb/articles/4403584098961-Incident-Overview-Technical-Details

7 https://attacksurfacetop10.com/top-ten-exposures

8 https://www.paloaltonetworks.com/resources/research/2020-unit42-incident-response-and-databreach-report

9 https://start.paloaltonetworks.com/asm-report

10 https://www.paloaltonetworks.com/prisma/unit42-cloud-threat-research-1h21